Geração de Texto com RAGs e Bases de Dados Vetoriais

Parte 1 - Conceitos de LLMs, RAGs e Bases de dados vetoriais

Introdução

A geração de texto sempre foi um desafio na área de processamento de linguagem natural. Com o surgimento da técnica de RAG e das bases de dados vetoriais, obtivemos um avanço significativo na qualidade e na relevância das respostas geradas por modelos de linguagem. Neste post, vamos explorar como essas tecnologias funcionam em conjunto e quais são os seus principais benefícios.

O que são LLMs e como funcionam?

LLMs (Large Language Models), ou Modelos de linguagem de grande escala, são modelos de aprendizado profundo que são pré-treinados em grandes quantidades de dados. Eles são capazes de gerar texto, traduzir idiomas, escrever diferentes tipos de conteúdo criativo e responder a suas perguntas de forma informativa.

Como funcionam?

Um modelo LLM funciona através de um processo complexo que envolve a representação de linguagem natural em formato numérico e o aprendizado profundo para gerar textos coerentes e contextualmente relevantes.

1. Representação de Palavras:

Vetorização: Ao contrário de métodos anteriores que utilizavam tabelas numéricas simples, os LLMs empregam vetores multidimensionais para representar cada palavra. Essa técnica, conhecida como incorporação de palavras, permite capturar relações semânticas e contextuais entre as palavras. Palavras com significados similares tendem a estar próximas umas das outras no espaço vetorial.

2. Pré-processamento:

Codificador: O texto de entrada é transformado em uma sequência de vetores numéricos através do codificador. Essa representação numérica captura o significado e o contexto das palavras, permitindo que o modelo compreenda a relação entre elas.

3. Aprendizado Profundo:

Redes Neurais: Os LLMs utilizam redes neurais artificiais, que são sistemas inspirados no cérebro humano. Essas redes são compostas por várias camadas de nós interconectados, cada uma responsável por extrair diferentes características do texto.

Treinamento: Os modelos são treinados em vastos conjuntos de dados textuais, aprendendo a prever a próxima palavra em uma sequência. Durante o treinamento, as redes neurais ajustam seus parâmetros internos para minimizar o erro entre a previsão e a palavra real.

4. Geração de Texto:

Decodificador: Após o processamento do texto de entrada, o decodificador utiliza o conhecimento adquirido durante o treinamento para gerar uma sequência de palavras que forma a saída desejada.

Probabilidades: O decodificador avalia a probabilidade de cada palavra ser a próxima na sequência, considerando o contexto e as informações extraídas do texto de entrada.

Saída: A sequência de palavras com maior probabilidade é selecionada como a saída final do modelo.

Treinamento de LLMs

O treinamento de LLMs é um processo iterativo e complexo que envolve a otimização de bilhões de parâmetros em redes neurais de grande escala.

1. Arquitetura de Redes Neurais:

Transformadores: A maioria dos LLMs utiliza a arquitetura de transformadores, que permite ao modelo processar a entrada em paralelo e capturar dependências de longo alcance.

Parâmetros: Os parâmetros do modelo, que incluem pesos e vieses, determinam a capacidade do modelo de mapear as entradas para as saídas desejadas.

Escala: A quantidade de parâmetros em um LLM pode chegar a bilhões, o que exige grandes quantidades de dados e poder computacional para o treinamento.

2. Conjunto de Dados:

Corpus Massivo: Os LLMs são treinados em vastos conjuntos de dados textuais, que podem incluir livros, artigos, código e páginas da web.

Qualidade dos Dados: A qualidade dos dados de treinamento é crucial para o desempenho do modelo. Dados de baixa qualidade ou com vieses podem levar a resultados indesejáveis.

3. Processo de Treinamento:

Autoaprendizagem: O treinamento é um processo de autoaprendizagem, onde o modelo ajusta seus parâmetros para maximizar a probabilidade de prever a próxima palavra em uma sequência, dada a sequência anterior.

Otimização: Técnicas de otimização, como o descenso do gradiente estocástico, são utilizadas para ajustar os parâmetros do modelo de forma eficiente.

Iterações: O processo de treinamento envolve múltiplas iterações sobre os dados de treinamento, onde o modelo é exposto a diferentes partes do conjunto de dados e seus parâmetros são ajustados.

4. Adaptação e Ajuste Fino:

Zero-shot Learning: Modelos pré-treinados podem ser usados para realizar diversas tarefas sem treinamento adicional, embora a precisão possa variar.

Few-shot Learning: Ao fornecer alguns exemplos de treinamento, o desempenho do modelo pode ser significativamente melhorado para uma tarefa específica.

Ajuste Fino: O ajuste fino envolve o treinamento de um modelo pré-treinado em um conjunto de dados menor e mais específico para a tarefa em questão.

Desafios dos LLMs

Os LLMs, apesar de suas capacidades avançadas, enfrentam alguns desafios que limitam seu potencial, alguns desafios são:

Viés nos dados: Os modelos de linguagem aprendem com os dados que são fornecidos durante o treinamento. Se esses dados forem tendenciosos, o modelo também será.

Geração de informações falsas: Os LLMs podem gerar textos que parecem plausíveis, mas que são factualmente incorretos ou sem sentido.

Falta de conhecimento factual: Os LLMs podem ter dificuldade em responder a perguntas que requerem conhecimento específico ou informações atualizadas.

Dificuldade em lidar com consultas complexas: As consultas complexas podem exigir que o modelo realize múltiplas inferências e raciocínios.

O que é uma bases de dados vetorial e como funciona?

Uma base de dados vetorial é um sistema de armazenamento de dados especializado em lidar com informações representadas na forma de vetores numéricos de alta dimensionalidade. Ao invés de armazenar dados em tabelas tradicionais (como em um banco de dados relacional), os dados são convertidos em representações matemáticas multidimensionais.

Como funciona?

Representação Vetorial:

Transformação: Os dados, que podem ser texto, imagens, áudio ou qualquer outro tipo de informação, são processados por algoritmos de aprendizado de máquina para gerar vetores numéricos.

Dimensões: Cada vetor possui um número específico de dimensões, e cada dimensão representa uma característica ou atributo do dado original. Por exemplo, um vetor que representa uma imagem pode ter dimensões correspondentes a cores, texturas, formas, etc.

Armazenamento:

Indexação: Os vetores são armazenados em um índice, que é uma estrutura de dados otimizada para buscas eficientes.

Organização: O índice organiza os vetores de forma a facilitar a recuperação de dados semelhantes.

Busca por Similaridade:

Consulta: Quando uma consulta é feita, ela também é convertida em um vetor.

Cálculo de Distância: A base de dados calcula a distância entre o vetor de consulta e todos os vetores armazenados no índice.

Retorno de Resultados: Os vetores mais próximos do vetor de consulta são retornados como resultados da pesquisa.

Métricas de Busca de Similaridades em Bases de Dados Vetoriais

A busca por similaridades é realizada através de algoritmos que calculam a distância entre vetores. A escolha da métrica depende da natureza dos dados, da dimensionalidade dos vetores e do nível de precisão desejado.

A forma como os dados são pré-processados (normalização, redução de dimensionalidade) pode impactar significativamente a performance das busca.

Conceito de Distância:

Distância Euclidiana: Mede a distância "reta" entre dois pontos em um espaço euclidiano. É uma boa opção para dados numéricos contínuos.

Distância de Cosseno: Mede o ângulo entre dois vetores. É ideal para dados que representam direções ou proporções, como vetores de palavras em um espaço vetorial.

Distância de Jaccard: Mede a similaridade entre conjuntos. É útil para dados binários ou categóricos.

Distância de Manhattan: Mede a distância entre dois pontos ao longo dos eixos de um grid, como se você estivesse se movendo em um tabuleiro de xadrez. É útil quando as diferenças em cada dimensão são igualmente importantes e você não pode "cortar caminho".

Outras Distâncias: Existem muitas outras métricas de distância, como a distância de Minkowski, etc., cada uma com suas próprias propriedades e aplicações.

Por que usar bases de dados vetoriais?

Dados não estruturados: Excelentes para lidar com dados não estruturados como texto e imagens, que são difíceis de representar em tabelas tradicionais.

Similaridade: Permitem encontrar dados semelhantes com base em suas características intrínsecas, e não apenas em palavras-chave.

Aprendizado de máquina: São fundamentais para aplicações de aprendizado de máquina, como recomendação de produtos, classificação de imagens e processamento de linguagem natural.

Escalabilidade: Podem lidar com grandes volumes de dados e consultas complexas de forma eficiente.

Desafios das Bases de Dados Vetoriais em Poucas Palavras

Dimensionalidade: Quanto maior a dimensão dos vetores, mais difícil encontrar similaridades.

Escolha da métrica: A escolha da métrica de distância impacta diretamente nos resultados.

Pré-processamento: Normalização e redução de dimensionalidade são cruciais.

Modelos de embedding: Diversos modelos com diferentes características e complexidades.

Gestão: Escalabilidade e atualização contínua são desafios.

Interpretabilidade: Dificuldade em entender o significado dos embeddings.

Custo computacional: Treinamento e inferência exigem muitos recursos.

O que é RAG e como funciona?

RAG (Retrieval Augmented Generation), ou Geração Aumentada por Recuperação, é uma técnica de inteligência artificial que integra a capacidade de busca em bancos de dados com a habilidade de geração de linguagem natural de LLMs. Essa integração permite que a IA gere textos mais precisos e contextualmente relevantes, ao complementar suas respostas com informações factuais e atualizadas extraídas de fontes externas.

Como funciona um RAG?

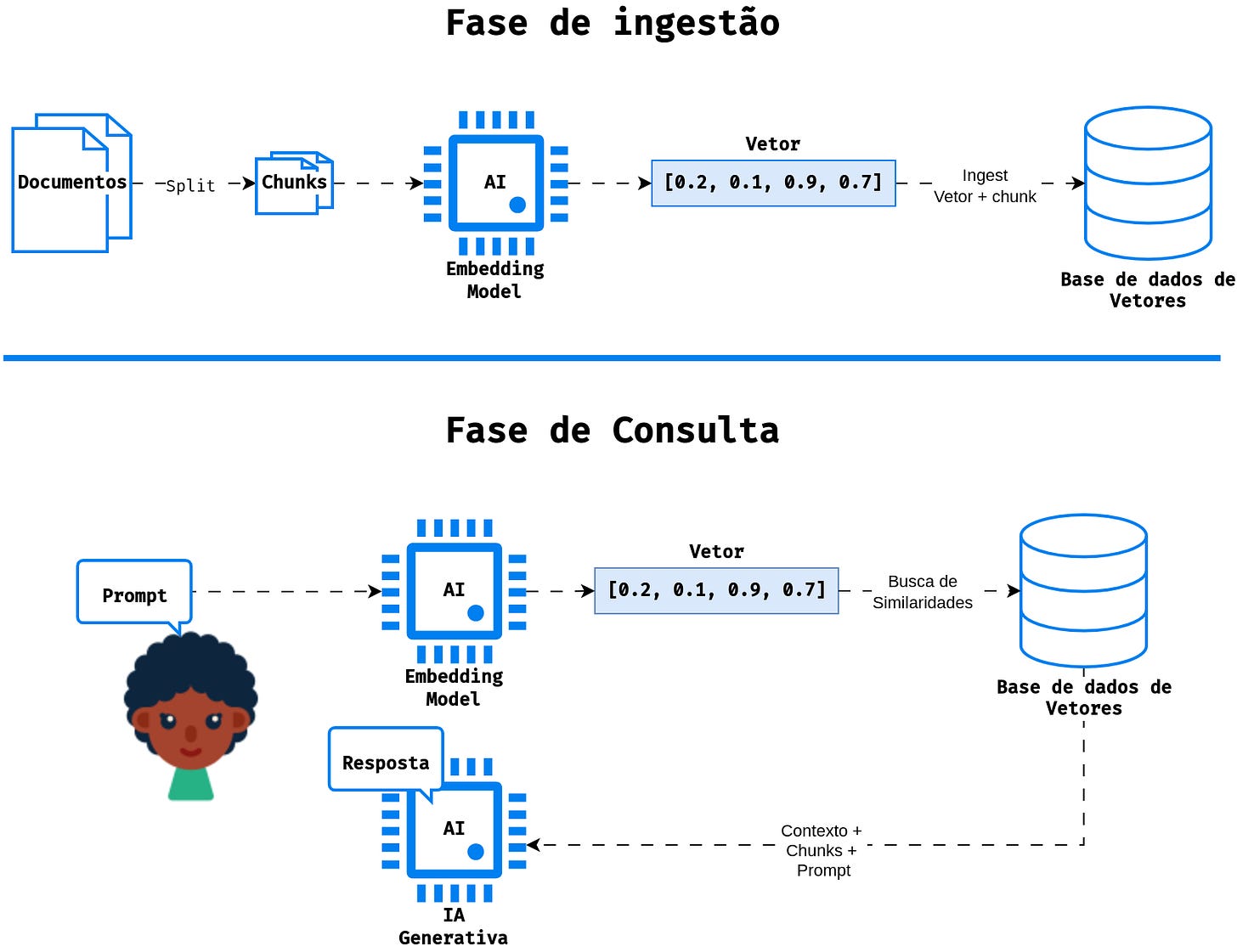

1. Fase de Ingestão: Construindo a Base de Conhecimento

Carregamento e Fragmentação: Um grande volume de documentos (livros, artigos, relatórios, etc.) é carregado e dividido em pedaços menores, chamados de "chunks". Essa divisão facilita o processamento e o armazenamento.

Criação de Embeddings: Cada chunk é transformado em uma representação numérica de alta dimensão, chamada de "embedding". Esse embedding captura a semântica e o significado do texto.

Armazenamento em Banco de Dados Vetorial: Os embeddings são armazenados em um banco de dados vetorial, uma estrutura de dados otimizada para realizar buscas por similaridade.

2. Fase de Consulta: Gerando Respostas Informativas

Consulta do Usuário: O usuário faz uma pergunta ao sistema.

Conversão da Consulta em Embedding: A pergunta do usuário também é transformada em um embedding.

Busca por Similaridade: O embedding da consulta é comparado com todos os embeddings armazenados no banco de dados. Os chunks com embeddings mais similares à consulta são recuperados.

Geração da Resposta: O LLM recebe a consulta original e os chunks relevantes como entrada. Ele utiliza esses dados para gerar uma resposta completa e informativa, baseada nas informações recuperadas do banco de dados.

Benefícios da utilização de RAGs

A Geração Aumentada por Recuperação (RAG) oferece uma série de vantagens significativas em comparação com os modelos de linguagem tradicionais:

Precisão e Atualização: Ao acessar bases de dados externas, os RAGs garantem que as informações fornecidas sejam precisas e estejam atualizadas, superando a limitação dos LLMs de estarem restritos aos dados de treinamento.

Embasamento Factual: As RAGs ajudam a evitar a geração de informações falsas ou alucinações, pois as respostas são baseadas em fatos e evidências extraídas de fontes confiáveis.

Relevância Contextual: Ao considerar o contexto da consulta, os RAGs geram respostas mais pertinentes e coerentes, evitando respostas irrelevantes ou fora do tópico.

Consistência: As RAGs promovem a consistência factual em suas respostas, reduzindo a probabilidade de contradições ou informações enganosas.

Personalização: A capacidade de buscar informações em bases de dados específicas permite que os RAGs gerem respostas personalizadas e adaptadas às necessidades do usuário.

Multimodalidade: Os RAGs podem ser utilizados para gerar respostas multimodais, combinando texto, imagens e outros formatos de dados.

Eficiência: O uso de bancos de dados vetoriais permite a recuperação rápida e precisa de informações relevantes, tornando o processo mais eficiente.

Desafios da utilização de RAGs

Apesar de seus inúmeros benefícios, a implementação e utilização de RAGs apresentam alguns desafios que precisam ser considerados:

1. Qualidade e Diversidade da Base de Dados:

Viés: Se a base de dados utilizada for tendenciosa, as respostas geradas pelos RAGs também poderão apresentar vieses.

Completude: Uma base de dados incompleta ou desatualizada pode limitar a capacidade do RAG de fornecer informações precisas e relevantes.

Diversidade: A falta de diversidade na base de dados pode levar a respostas limitadas e pouco representativas.

2. Complexidade da Arquitetura:

Integração: A integração entre o modelo de linguagem e a base de dados pode ser complexa e exigir um conhecimento profundo de ambas as tecnologias.

Escalabilidade: A escalabilidade do sistema pode ser um desafio, especialmente ao lidar com grandes volumes de dados e consultas complexas.

3. Custo Computacional:

Processamento: O treinamento e a execução de modelos de linguagem de grande porte, juntamente com a busca em bases de dados, podem exigir um alto poder computacional.

Armazenamento: A manutenção de grandes bases de dados também pode gerar custos significativos de armazenamento.

4. Privacidade e Segurança:

Proteção de dados: É fundamental garantir a proteção dos dados armazenados na base de dados, evitando vazamentos e acessos não autorizados.

Compliance: As aplicações que utilizam RAGs devem estar em conformidade com as leis e regulamentos de proteção de dados.

5. Interpretabilidade:

Caixa preta: É difícil entender como os RAGs chegam a suas conclusões, o que pode limitar a confiança nos resultados.

6. Manutenção:

Atualização: As bases de dados precisam ser constantemente atualizadas para garantir a precisão das informações.

Re treinamento: Os modelos de linguagem também podem precisar ser re treinados periodicamente para acompanhar as mudanças na linguagem e no conhecimento.

7. Custo-Benefício:

Investimento: A implementação de um sistema RAG pode exigir um investimento significativo em infraestrutura, pessoal e desenvolvimento.

Retorno: É preciso avaliar cuidadosamente o retorno sobre o investimento, considerando os benefícios e os desafios da tecnologia.

Arquitetura básica do uso de LLMs e RAGs para construção de aplicações de chats com IAs generativas

Na parte 2 deste post trarei uma aplicação de exemplo implementando a arquitetura básica descrita na imagem com as seguintes tecnologias: Java 21, LangChain4J, QDrant Vector Database, etc.

Se subscreva para ser notificado!